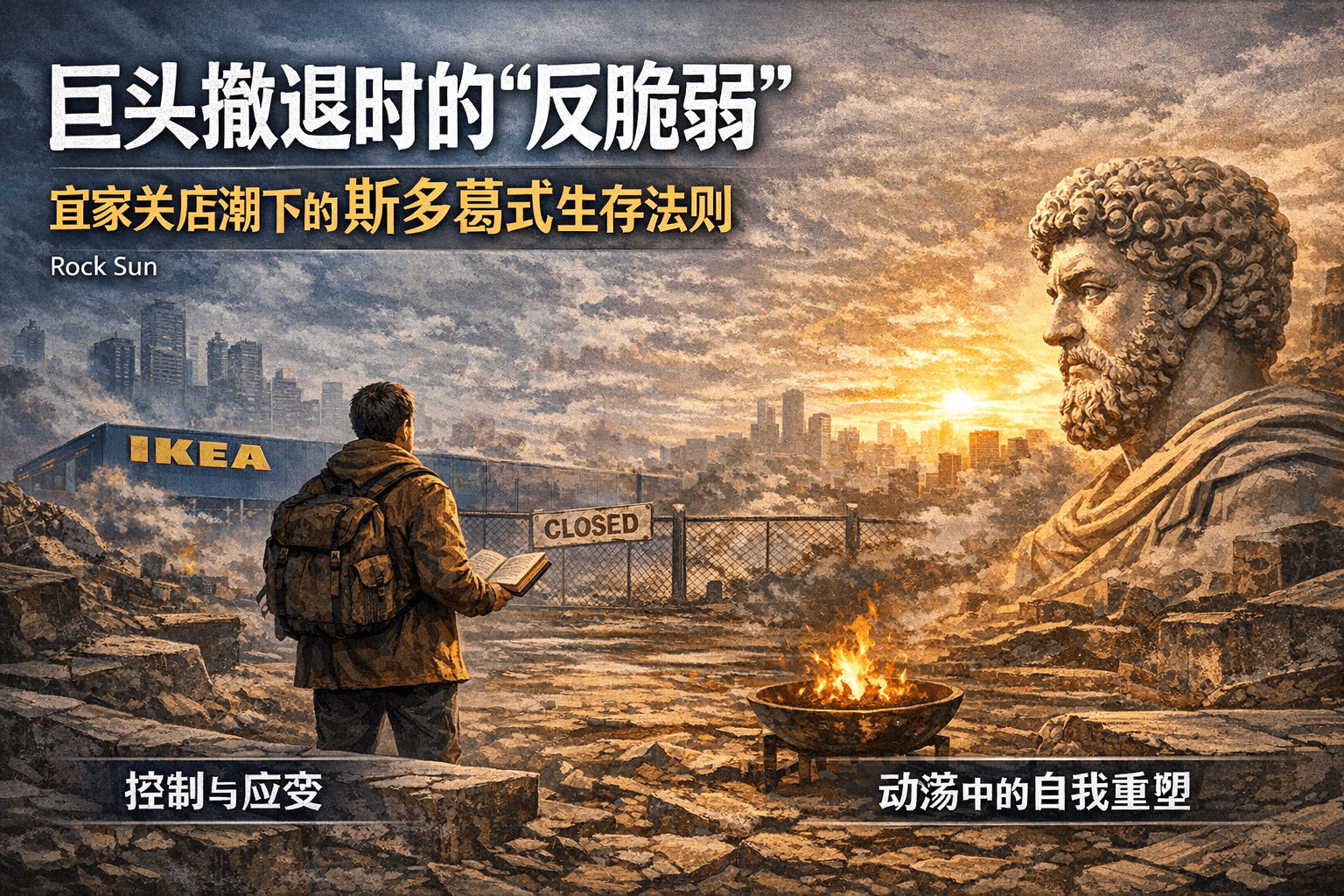

巨头撤退时的“反脆弱”:宜家关店潮下的斯多葛式生存法则

宜家(IKEA)中国近日确认关闭7家门店。那个蓝黄相间、曾为无数人描绘“中产生活蓝图”的巨头,正在收缩它的防线。

这一消息在社交媒体上引发的震动,远超商业新闻本身。因为它触动了当下社会最敏感的神经:连这种级别的跨国巨头都在“断臂求生”,作为普通个体的我们,安全感究竟该安放何处?

与其陷入群体性的焦虑,不如让我们戴上斯多葛主义的眼镜,借由自由市场的逻辑,透过这次“撤退”看清生存的本质。

一、 市场没有慈悲,只有反馈

首先,我们需要用理性的手术刀剔除情绪。

在自由市场经济学中,宜家的关店并非“失败”,而是资源配置的纠错。当某些门店的边际收益低于边际成本,及时止损是企业最道德的商业决策。这正是市场机制在发挥作用——它冷酷地淘汰低效产能,迫使资本流向更高效的渠道(例如宜家正在加大的线上投入)。

我们不需要为巨头哭泣。 市场经济的活力恰恰源于这种残酷的优胜劣汰。然而,这种宏观的“合理性”,落在个体头上,往往就是一座大山。

这就是为什么我们需要引入斯多葛哲学的智慧。

二、 控制权二分法:你的焦虑源于“越界”

斯多葛派哲学家爱比克泰德(Epictetus)曾说:“有些事情由我们控制,有些事情不由我们控制。”

当我们因为宜家关店、裁员潮或宏观经济下行而感到恐慌时,我们其实犯了一个根本性的错误:我们将幸福和安全感寄托在了哪怕一点点都不属于我们控制的事物上。

- 不可控因素:跨国公司的战略调整、全球供应链的波动、房地产周期的兴衰。这些就像天气一样,你可以预测,但无法改变。

- 可控因素:你的职业技能、你的储蓄率、你对消费欲望的控制、以及你面对坏消息时的反应。

在这个巨头撤退的时代,最大的风险不是失业,而是**“依附心态”**。如果你认为你的安全感来自于一家“大而不倒”的公司,或者是某种稳定的行业红利,那么你就像是把房子建在了沙滩上。

三、 自由市场的个体觉醒:做自己的CEO

如果说斯多葛主义教我们修筑内心的防线,那么自由市场理论则教我们如何进攻。

在劳动力市场中,你不是“员工”,你是一家出售服务的“微型企业”。你的雇主只是你的一个“大客户”。

当宜家因为市场变化而调整策略时,作为个体的你也必须拥有同样的灵活性。纳西姆·塔勒布提出的**“反脆弱”**(Antifragile)概念在这里至关重要:

- 去中心化你的收入:不要只依赖一个客户(雇主)。在自由市场中,多渠道的技能变现能力是生存的底气。

- 拥抱波动:温室里的花朵经不起风雨。那些在单一岗位上重复机械劳动的人,在市场震荡中最脆弱;而那些不断适应新技术、解决新问题的人,反而能从混乱中获益。

四、 行动指南:构建你的诺亚方舟

结合斯多葛智慧与市场逻辑,我们可以制定一套具体的行动方案,以此应对外部世界的崩塌:

-

实施“防御性悲观”(Premeditatio Malorum) 每天花5分钟想象最坏的情况:如果明天我也失去了工作,我该怎么办?这种斯多葛式的心理预演,能让你在危机真正来临时保持冷静,并促使你现在就开始准备备用方案。

-

积累“F* You Money”** 斯多葛主义推崇节制(Temperance)。在这个消费主义退潮的时代,削减不必要的欲望,提高储蓄率。存款不仅是钱,它是你随时可以说“不”的自由权,是你在这个动荡市场中的护城河。

-

投资于“便携式资产” 不要依恋平台的光环。投资那些如果你离开公司依然属于你的东西:你的知识、你的声誉、你的健康、你的思维模型。这些是没有任何人能夺走的私有产权。

结语:在废墟上跳舞

马可·奥勒留曾在战火纷飞的前线写下:“阻碍行动的因素会成为行动的动力,挡在路上的巨石会成为路的一部分。”

宜家的关店、经济的周期,这些都是挡在路上的巨石。你可以选择在石头前哭泣,哀叹旧时光的逝去;也可以选择踩在石头上,以此为台阶,去构建一个更独立、更强韧、更清醒的自我。

这就是斯多葛主义者的自由市场生存之道:接受不可控的寒冬,但在自己的领地上,点燃永不熄灭的火。